-

Par Jean François Longy

Par Jean François Longy

- 25/03/2025 à 19:01

- Glossaire

Qu’est-ce que le fichier robots.txt ?

Un standard du protocole d’exclusion des robots

Le fichier robots.txt constitue un élément pivot du protocole d'exclusion des robots, permettant aux gestionnaires de sites web de communiquer avec les moteurs de recherche sur les pages à explorer ou à ignorer. Ce fichier texte, situé à la racine du site, joue un rôle essentiel dans l'optimisation du crawl. En spécifiant les répertoires ou fichiers à exclure, il protège des informations sensibles ou en cours de développement tout en allégeant le travail des bots d'indexation, optimisant ainsi les ressources du serveur. Cependant, il est crucial de noter que les directives du robots.txt ne sont que des suggestions que les robots peuvent ou non suivre. En exploitant ce standard, les spécialistes SEO assurent une indexation stratégique, évitant la duplication de contenu et préservant la performance du site. L'efficacité du fichier réside dans sa rédaction précise, nécessitant une compréhension approfondie des bonnes pratiques en SEO pour un déploiement optimal.

- User-agent: Le nom d'un robot auquel les directives s'appliquent.

- Disallow: Directive indiquant les pages à ne pas explorer.

- Sitemap: Emplacement du fichier XML pour l'indexation complète.

Différence entre robots.txt et meta robots

Dans le domaine du SEO, la distinction entre le fichier robots.txt et la balise meta robots est fondamentale pour optimiser la gestion de l'indexation par les moteurs de recherche. Le fichier robots.txt est utilisé pour donner des instructions globales aux robots d'indexation sur les parties d'un site web qui peuvent ou ne peuvent pas être explorées. Il est placé à la racine du site et affecte tous les moteurs de recherche qui le respectent. En revanche, la balise meta robots est insérée dans le code HTML de pages spécifiques et offre un contrôle plus granulaire. Elle permet de spécifier des actions telles que l'indexation ou le suivi des liens sur une page individuelle. Alors que le robots.txt agit en amont pour limiter l'accès à des sections entières du site, la balise meta robots intervient directement au niveau des pages pour affiner les consignes d'indexation ou de non-indexation. Il est crucial pour les webmasters de bien comprendre et utiliser ces deux outils pour assurer une visibilité optimale et protéger des informations sensibles tout en maximisant le référencement naturel.

- Indexation : Processus par lequel les moteurs de recherche analysent et enregistrent le contenu web.

- Noindex : Directive pour les robots indiquant de ne pas indexer une page.

- Nofollow : Directive pour éviter que les liens de la page transmettent de l'autorité.

Pourquoi a-t-on besoin d’un fichier robots.txt ?

Contrôler l’exploration des pages par les moteurs de recherche

Contrôler l'exploration des pages par les moteurs de recherche est une pratique essentielle pour toute stratégie SEO efficace. Ceci peut être réalisé à travers l'utilisation combinée de fichiers robots.txt et de balises meta robots. Le fichier robots.txt, situé à la racine du site, sert à guider les crawlers sur les pages à éviter, permettant ainsi de réduire la charge sur le serveur et de protéger des sections critiques du site. Par ailleurs, les balises meta robots offrent un contrôle à un niveau plus granulaire, permettant de spécifier des directives d’indexation pour les pages individuelles, telles que "noindex" pour éviter que certains contenus ne soient indexés par les moteurs de recherche. En optimisant l’utilisation de ces outils, les webmasters peuvent s'assurer que les ressources clés du site sont correctement indexées tout en améliorant l'efficacité de l'exploration, ce qui est crucial pour maintenir et renforcer la visibilité sur les moteurs de recherche tout en protégeant le contenu stratégique.

- Crawl budget : Quantité de ressources qu'un moteur de recherche alloue pour explorer un site.

- Disallow : Directive dans robots.txt empêchant l'exploration de certaines URL.

- Noindex : Directive de meta robots spécifiant de ne pas indexer la page.

Gérer l’accès aux ressources sensibles

Gérer l'accès aux ressources sensibles sur un site web est un enjeu majeur pour toute entreprise soucieuse de sa sécurité et de sa stratégie SEO. Utiliser efficacement des fichiers robots.txt et des balises meta robots permet d’assurer que certaines parties du site ne soient pas accessibles aux moteurs de recherche et donc protégées contre des accès non souhaités. Le fichier robots.txt peut empêcher l’exploration de répertoires entiers, tandis que les balises meta robots offrent la possibilité de gérer l'indexation à un niveau de page individuel. Ces outils permettent non seulement de sécuriser des données sensibles ou en développement, mais aussi de s’assurer que les efforts de crawl des moteurs de recherche se concentrent sur les contenus les plus pertinents au référencement du site. L’utilisation judicieuse de ces outils permet ainsi de minimiser les risques d'exposition non désirée tout en maximisant l’efficacité du SEO global du site.

- Confidentialité : Protéger des informations sensibles non destinées à être publiquement accessibles.

- Exclusion : Utiliser des directives Disallow dans robots.txt pour bloquer certains parcours.

- Contrôle d’indexation : Employez noindex dans les meta robots pour empêcher l'indexation de pages spécifiques.

Optimiser le budget de crawl des moteurs de recherche

Optimiser le budget de crawl des moteurs de recherche est essentiel pour maximiser l'efficacité du référencement SEO, particulièrement pour les plateformes B2B. Une gestion prudente du budget de crawl implique une hiérarchisation stratégique des pages à explorer par les moteurs de recherche, en utilisant judicieusement des fichiers robots.txt pour exclure les sections peu pertinentes et réserver le crawl pour les pages stratégiques. Hyperlinker.ai intervient en tant qu'outil clé, facilitant la surveillance et l'ajustement continu des stratégies de netlinking, en veillant à ce que le crawl soit dirigé vers des contenus de grande valeur qui améliorent efficacement le classement sur les moteurs de recherche. Grâce à des métriques en temps réel et des analyses avancées, les entreprises peuvent affiner leur approche pour garantir un ROI optimal et une performance SEO soutenue. Ces actions, lorsqu'elles sont bien coordonnées, permettent d'utiliser au mieux les ressources allouées au crawl, renforçant ainsi la visibilité et l'autorité du site tout en évitant une exploration inefficace de pages inutiles.

- Gestion du crawl : Processus de régulation de l'exploration des pages par les moteurs de recherche.

- Page stratégique : Section du site de haute valeur ajoutée, prioritaire pour le crawl.

- Analyse en temps réel : Surveillance continue des performances pour ajustement immédiat.

Comment fonctionne un fichier robots.txt ?

Le principe des règles d’autorisation et d’interdiction

En matière de SEO, le principe des règles d’autorisation et d’interdiction repose sur une gestion minutieuse des accès et de l'indexation des pages web par les moteurs de recherche. Le fichier robots.txt est l’outil principal utilisé pour définir ces règles, où chaque directive spécifie si les crawlers sont autorisés ou non à explorer certaines sections du site. En fonction des besoins spécifiques du site, un webmaster peut inclure des directives «Allow» pour permettre l'exploration, ou «Disallow» pour restreindre l'accès à certaines URL. Cette gestion granulaire est cruciale non seulement pour sécuriser les contenus sensibles, mais aussi pour diriger l’attention des robots vers les pages stratégiques qui renforceront le positionnement du site dans les résultats des moteurs de recherche. De plus, ces directives permettent d'optimiser le «crawl budget», en concentrant les ressources d'exploration sur les sections du site qui offrent le plus de valeur ajouté à l’indexation et au classement SEO.

- Directive « Allow » : Permet l'exploration de certaines sections du site par les moteurs de recherche.

- Directive « Disallow » : Restreint l'accès aux sections spécifiées du site.

- Crawl budget : Allocation par un moteur de recherche des ressources d'exploration pour un site.

Comment les moteurs de recherche interprètent les directives

Les moteurs de recherche suivent un ensemble de règles précises lorsqu'ils interprètent les directives des fichiers robots.txt et des balises meta robots. Ces directives guident les bots dans la gestion de l'exploration et de l'indexation des pages web. Lorsqu'un robot d'indexation atteint un site, il consulte d'abord le fichier robots.txt pour déterminer les parties du site qu'il est autorisé à explorer. Les instructions spécifiques, telles que «Disallow» ou «Allow», indiquent respectivement les URL interdites ou autorisées à être explorées. Toutefois, toutes les directives ne sont pas impérativement suivies, car certains moteurs de recherche peuvent choisir d'ignorer les restrictions pour accéder à un contenu jugé important. Par ailleurs, les balises meta robots, insérées dans le HTML d'une page, orientent les bots sur la manière de traiter des pages spécifiques une fois qu'elles ont été explorées, notamment à travers des commandes telles que «noindex» ou «nofollow». Cette interprétation des directives est essentielle pour assurer une indexation efficace tout en évitant les erreurs de visibilité sur le web.

- Disallow : Interdit l'exploration de certaines URL.

- noindex : Empêche l'indexation de la page par les moteurs de recherche.

- nofollow : Indique de ne pas suivre les liens de la page.

Les limites du fichier robots.txt

Bien que le fichier robots.txt soit un outil influent pour orienter les bots des moteurs de recherche, il n’est pas exempt de limitations. Premièrement, il est crucial de comprendre que les directives dans le robots.txt ne sont que des recommandations. Certains robots, notamment ceux ayant des intentions malveillantes, peuvent choisir d'ignorer complètement ces instructions, accédant ainsi aux pages supposément protégées. De plus, les moteurs de recherche traditionnels suivent généralement ces directives, mais en cas de conflits ou d'erreurs de syntaxe dans le fichier, l'interprétation peut être imprécise. Une autre limitation réside dans le fait que le fichier robots.txt n'empêche pas l'indexation d'une URL si son contenu est référencé ailleurs sur le web. Pour une protection efficace, il faut donc envisager des méthodes complémentaires comme l'utilisation de balises meta ou des restrictions d'accès par mot de passe. Par conséquent, bien que puissant, le robots.txt doit être conçu et utilisé avec soin, dans le cadre d'une stratégie de gestion des accès plus large pour assurer une protection optimale des contenus sensibles et une indexation adaptée.

- Recommandation non contraignante : Les directives peuvent être ignorées par certains bots.

- Interprétation variable : Les erreurs de syntaxe nuisent à une interprétation correcte.

- Limitation d'indexation : N'empêche pas l'indexation via des référencements externes.

Où placer le fichier robots.txt sur un site web ?

Emplacement stratégique et accessibilité

Le positionnement du fichier robots.txt constitue un aspect crucial de son efficacité dans l'encadrement des robots d'indexation. Idéalement, ce fichier doit être localisé à la racine du domaine, c'est-à-dire à l'adresse https://www.nomdusite.com/robots.txt. Cet emplacement stratégique est indispensable car c'est le premier répertoire que les moteurs de recherche vérifient lors de leur visite. En effet, tout écart de localisation empêcherait les robots d'accéder aux directives du fichier, compromettant ainsi l'ensemble de la stratégie de gestion des accès mise en place. En plus de l'emplacement, il est impératif que le fichier soit accessible, sans restriction, afin d'assurer que les directives peuvent être lues par tous les crawlers. Toute restriction à l'accès au fichier robots.txt peut entraîner des anomalies dans l'exploration du site et entraver la gestion efficace des ressources par les moteurs de recherche. Ainsi, des pratiques telles que la vérification régulière de l'accessibilité du fichier et la maintenance de son contenu sont essentielles pour préserver la stratégie SEO globale du site.

- Racine du domaine : Emplacement optimal pour le fichier robots.txt.

- Accessibilité : Assurer une disponibilité sans restriction.

- Maintenance : Vérifications régulières pour garantir l'efficacité.

Vérifier la disponibilité du fichier robots.txt

Assurer la disponibilité du fichier robots.txt est un aspect fondamental pour une gestion optimale de l'exploration des moteurs de recherche. Pour ce faire, il est important de vérifier que le fichier est non seulement correctement placé à la racine du site, mais également accessible sans entraves. Un moyen simple de valider cette accessibilité est de simuler l'accès en tapant directement l'URL correspondante dans un navigateur, par exemple https://www.nomdusite.com/robots.txt. Si le fichier ne se charge pas comme prévu, cela peut indiquer des problèmes d'accessibilité qui nécessitent une résolution immédiate. En outre, l'utilisation d'outils SEO et de surveillance spécifiques peut aider à automatiser cette vérification, garantissant que toute indisponibilité est rapidement détectée et corrigée. Ceci est essentiel pour éviter la confusion parmi les robots d'indexation qui pourraient ne pas respecter les directives en cas d'inaccessibilité du fichier. En fin de compte, maintenir une vérification régulière de la disponibilité du robots.txt contribue non seulement à sécuriser les accès souhaités, mais assure également que les efforts d'optimisation SEO ne soient pas contrecarrés par des erreurs d'accès.

- Vérification manuel : Tester l'accès direct via un navigateur.

- Outils de surveillance : Automatiser la vérification de l'accessibilité.

- Détection et correction : Action rapide en cas d'inaccessibilité.

Quelle est la syntaxe du fichier robots.txt ?

Les principales directives et leur utilisation

Le fichier robots.txt repose sur des directives clés qui orientent les moteurs de recherche lors de l'exploration des pages web. L'une des directives les plus fondamentales est User-agent, qui spécifie les robots d'indexation auxquels s'applique le reste des règles. En complément, la directive Disallow permet de bloquer l'exploration de pages ou de répertoires spécifiques, assurant ainsi la confidentialité de certains contenus. À l'opposé, la directive Allow peut être utilisée pour autoriser l'accès à des sous-sections au sein d'une restriction plus large imposée par Disallow. Une autre directive importante est Sitemap, qui indique l'emplacement du fichier sitemap XML, fournissant aux moteurs de recherche une carte claire de la structure du site pour une indexation efficiente. En utilisant ces directives de manière optimale, les administrateurs de sites peuvent contrôler de manière précise quels contenus sont accessibles aux bots d'indexation, améliorant ainsi la gestion du crawl budget et protégeant les informations stratégiques.

- User-agent : Détermine les bots cibles des directives.

- Disallow : Empêche l'accès à des URL spécifiques.

- Allow : Autorise l'exploration de sections au sein d'une restriction.

- Sitemap : Indique l'emplacement du fichier sitemap XML pour l'indexation.

Tableau des directives courantes et explications

Les directives utilisées dans un fichier robots.txt jouent un rôle crucial dans la gestion de l'accès des robots d'indexation à un site web. Voici un tableau rassemblant les directives les plus courantes et leurs explications succinctes :

| Directives | Explication |

| User-agent | Spécifie à quel(s) robot(s) les directives s'appliquent. Utilisé pour cibler des bots spécifiques. |

| Disallow | Empêche l'accès à une page ou un répertoire particulier. Utilisé pour protéger des contenus sensibles. |

| Allow | Permet d'autoriser l'accès à des parties spécifiques dans un répertoire bloqué par Disallow. |

| Sitemap | Indique l'emplacement du fichier sitemap XML. Aide à orienter les robots pour une indexation complète. |

| Crawl-delay | Spécifie un délai entre les chargements de page pour éviter la surconsommation des ressources serveur. |

L'utilisation efficace de ces directives permet aux gestionnaires de sites de contrôler l'interaction avec les moteurs de recherche, optimisant ainsi le SEO et protégeant les données sensibles.

Exemples de règles pour différents cas d’usage

L'utilisation des règles dans le fichier robots.txt peut être adaptée pour répondre à divers besoins spécifiques d'un site web. Voici quelques exemples pratiques :

- Blockage complet de l'accès : Pour un site en développement ou une section en maintenance, utiliser la règle suivante : User-agent: * Disallow: /

- Bloquer un répertoire spécifique : Empêcher l'exploration du dossier d'administration pour protéger le site : User-agent: * Disallow: /admin/

- Autoriser l'accès à un fichier spécifique dans un répertoire bloqué : Permettre l'accès à important.html dans un dossier restreint : User-agent: * Disallow: /documents/ Allow: /documents/important.html

- Consignes pour des bots spécifiques : Bloquer uniquement Googlebot sur certaines pages : User-agent: Googlebot Disallow: /private/

En mettant en œuvre ces règles, les gestionnaires de sites peuvent mieux contrôler l'accès des moteurs de recherche aux contenus sensibles, tout en optimisant les ressources pour le SEO.

Comment créer et modifier un fichier robots.txt ?

Outils et méthodes pour générer un fichier robots.txt

Créer un fichier robots.txt peut être grandement facilité par l'utilisation d'outils et de méthodes adaptés qui s'adressent aussi bien aux novices qu'aux experts en SEO. Parmi les outils les plus répandus, on trouve des générateurs en ligne tels que le Robots.txt Generator de Google, qui offre une interface intuitive pour construire un fichier précis en spécifiant les directives appropriées pour différents bots. HyperOptimizer, intégré à HyperLinker.ai, propose également des fonctionnalités avancées pour personnaliser et optimiser des fichiers robots.txt dans le cadre de campagnes SEO stratégiques. Pour ceux qui préfèrent un contrôle total via un éditeur de texte, utiliser un logiciel comme Notepad++ peut s'avérer utile pour rédiger manuellement le fichier, garantissant ainsi une totale personnalisation. Il est essentiel de compléter ces approches avec des outils de test et de validation, tels que l'outil de test de Google Search Console, afin de vérifier l'efficacité du fichier avant son déploiement. En combinant ces outils et méthodes, les entreprises peuvent créer un fichier robots.txt qui augmente la visibilité tout en sécurisant les ressources sensibles du site.

- Générateurs en ligne : Pour une création simplifiée des fichiers.

- Éditeurs de texte : Pour la personnalisation manuelle des directives.

- Outils de validation : Afin de tester l'efficacité et la précision du fichier avant sa mise en œuvre.

Bonnes pratiques pour une configuration efficace

Pour configurer un fichier robots.txt de manière efficace, il est essentiel d'adopter certaines bonnes pratiques. Celles-ci commencent par la clarté et la précision : chaque directive doit être soigneusement rédigée pour éviter toute ambiguïté pour les crawlers. Une rédaction concise aide à réduire les erreurs, et éviter l'utilisation excessive de Disallow prévient le blocage involontaire de parties essentielles du site. De plus, intégrer la directive Sitemap dans le fichier robots.txt est recommandé pour optimiser l’indexation en orientant les robots directement vers le plan du site. La mise en œuvre de directives spécifiques, adaptées à certains User-agents, permet également de personnaliser l'exploration des bots, assurant que toutes les ressources importantes reçoivent l’attention nécessaire. Enfin, effectuer régulièrement des vérifications et des tests avec des outils SEO est crucial pour s'assurer que le fichier reste à jour et que ses directives répondent toujours aux objectifs SEO du site. Ces pratiques garantissent une gestion optimale des ressources web tout en améliorant la stratégie globale de référencement.

- Clarté : Directives précises et sans ambiguïté.

- Intégration de Sitemap : Favorise une indexation complète et efficace.

- Personnalisation des User-agents : Adaptation des règles selon les besoins spécifiques des robots.

- Vérification périodique : Assure la pertinence continue du fichier robots.txt.

Erreurs fréquentes à éviter

L'élaboration d'un fichier robots.txt nécessite une attention particulière pour éviter des erreurs qui pourraient nuire à l'indexation et à la performance SEO. Une des erreurs les plus courantes est de bloquer accidentellement l'accès complet au site en utilisant la directive Disallow: /, ce qui empêche tous les moteurs de recherche d'explorer le site. Il est également crucial de s'assurer que le fichier est correctement placé dans la racine du domaine pour qu'il soit détectable par les robots. L'omission de la mise à jour du fichier en fonction des modifications du site est une autre faute fréquente, qui peut entraîner des inconséquences dans le référencement. Enfin, ignorer l'utilisation de la directive Sitemap peut limiter l'efficacité de l'indexation en ne fournissant pas un guide clair aux robots pour explorer le site en profondeur. En évitant ces erreurs et en vérifiant régulièrement le fichier, les gestionnaires de sites peuvent s'assurer que le fichier robots.txt soutient efficacement leur stratégie SEO.

- Blocage involontaire : Éviter d'utiliser Disallow: / de manière imprudente.

- Mauvais placement : S'assurer que le fichier se trouve à la racine du domaine.

- Absence de mise à jour : Adapter régulièrement le fichier aux évolutions du site.

- Non-utilisation de Sitemap : Intégrer la directive Sitemap pour guider les robots.

Comment tester et vérifier l’implémentation du fichier robots.txt ?

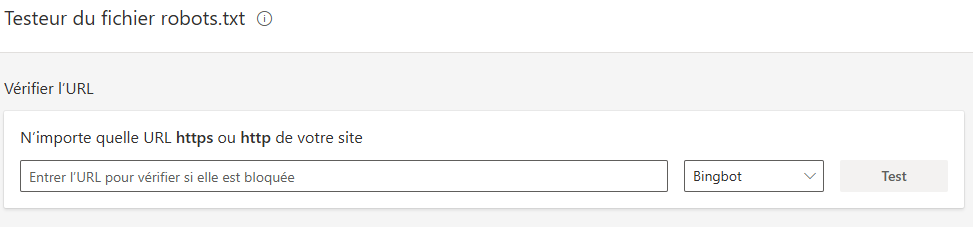

Les outils de test fournis par Google et Bing

Les outils de test fournis par Google et Bing sont indispensables pour vérifier l'exactitude et l'efficacité de votre fichier robots.txt. Google propose l'outil de test intégré dans la Search Console, qui permet de simuler le comportement des crawlers et de vérifier si certaines URLs sont bloquées ou autorisées. Cet outil aide à identifier rapidement les erreurs potentielles dans la configuration du fichier, évitant ainsi des conséquences négatives sur le référencement. De même, Bing offre des fonctionnalités similaires dans sa Webmaster Tools, permettant aux utilisateurs de tester et d'analyser l'accessibilité des pages par ses bots. Utiliser ces outils régulièrement est une pratique recommandée pour garantir que tous les aspects de votre stratégie SEO fonctionnent de manière harmonieuse. Ces plateformes fournissent des informations détaillées et des conseils pour optimiser le fichier, renforçant ainsi la visibilité et la performance du site sur les moteurs de recherche majeurs.

- Google Search Console : Tester et valider le fichier robots.txt pour Googlebot.

- Bing Webmaster Tools : Vérifier l'accessibilité et l'indexation pour Bingbot.

- Simulation de crawl : Identifier les éventuels problèmes liés aux directives.

Analyser l’impact des directives sur le crawl

L'impact des directives du fichier robots.txt sur le crawl d'un site doit être analysé avec soin pour optimiser les pratiques SEO. Chaque directive, que ce soit Allow ou Disallow, influence directement la façon dont les moteurs de recherche explorent et indexent le contenu du site. Une configuration minutieuse garantit que les pages essentielles à la stratégie de SEO reçoivent l'attention nécessaire des bots, tandis que les sections moins pertinentes ou confidentielles sont efficacement exclues du crawl. L'analyse régulière des journaux de serveur aide à comprendre comment les directives influencent la fréquence et la profondeur du crawl, permettant des ajustements proactifs. Par ailleurs, l'intégration d'outils analytiques avancés, tels qu'HyperOptimizer de HyperLinker.ai, permet de visualiser et d'affiner l'efficacité des règles, améliorant ainsi le retour sur investissement en référencement naturel. Cette analyse contribue à une gestion rationnelle du crawl budget, évitant les inefficacités et maximisant l'indexation de contenu précieusement identifié pour son rôle stratégique.

- Configuration minutieuse : Assurer l'indexation des pages clés.

- Analyse des journaux : Évaluer l'impact réel des directives sur le crawl.

- Outils analytiques : Optimiser continuellement grâce à des données précises.

Interprétation des erreurs et avertissements

L'interprétation des erreurs et des avertissements signalés par les outils de test des fichiers robots.txt est cruciale pour maintenir une stratégie SEO efficace. Ces alertes, souvent générées lors de l'analyse des fichiers par des plateformes comme Google Search Console ou Bing Webmaster Tools, fournissent des indications précieuses sur les éventuelles incohérences dans la configuration des directives. Par exemple, un avertissement typique peut concerner une directive Disallow erronée qui bloque l'accès à des ressources critiques pour le SEO, conduisant à une baisse de l'indexation et de la visibilité du site. De même, des erreurs de syntaxe non corrigées peuvent causer des problèmes d'interprétation par les crawlers, affectant négativement le rang des pages dans les résultats de recherche. Il est essentiel que les gestionnaires de sites s'engagent activement dans le suivi de ces avertissements, en analysant et en rectifiant rapidement les erreurs identifiées. En utilisant des outils avancés comme HyperOptimizer, les utilisateurs peuvent non seulement détecter, mais aussi comprendre l'impact de ces erreurs et ajuster leurs stratégies en conséquence pour optimiser efficacement le référencement.

- Analyse proactive : Suivre et résoudre les erreurs signalées pour éviter une indexation incorrecte.

- Avertissements typiques : Identifier les problèmes potentiels liés à des directives incorrectes.

- Outils avancés : Utiliser des solutions analytiques pour optimiser la configuration et le suivi.

Quels sont les problèmes courants liés au fichier robots.txt ?

Blocage intempestif des contenus stratégiques

Le phénomène de blocage intempestif des contenus stratégiques dans un fichier robots.txt peut représenter un défi majeur pour l'efficacité du SEO. Cela survient lorsque des règles inappropriées de type Disallow sont mises en place, interdisant involontairement l'accès des crawlers à des sections critiques du site, telles que des pages de produits, des articles de blog ou autres contenus précieux pour le référencement. Une telle erreur peut résulter en une perte significative de trafic organique, car les moteurs de recherche ne parviennent pas à indexer correctement ces pages clés. Il est donc impératif pour les gestionnaires de sites de régulièrement auditer et affiner les configurations de leur fichier robots.txt afin de garantir que les ressources stratégiques ne soient pas mises en quarantaine par erreur, compromettant ainsi la visibilité globale du site. L'usage d'outils d'audit SEO, couplé à une vigilance constante, est nécessaire pour identifier et rectifier de manière proactive ces blocages inattendus.

- Règles inappropriées : Vérifications constantes nécessaires pour protéger les contenus critiques.

- Perte de trafic : Impacts négatifs potentiels sur le référencement et la visibilité.

- Audit régulier : Utilisation d'outils SEO pour diagnostiquer et corriger les erreurs de configuration.

Configuration erronée entraînant une désindexation

La configuration erronée d'un fichier robots.txt peut entraîner une désindexation involontaire de pages essentielles, impactant gravement la performance SEO d’un site. Un des risques majeurs réside dans l'application incorrecte des directives Disallow, pouvant empêcher les moteurs de recherche d'accéder à des segments critiques du site. Par ailleurs, des erreurs de syntaxe, comme l'oubli d'un slash final ou un mauvais positionnement des directives User-agent, peuvent engendrer des interprétations incorrectes par les crawlers, entraînant une non-indexation des pages prévues pour être visibles dans les résultats de recherche. Ces erreurs peuvent mener à une diminution significative du trafic organique et à une perte de positionnement dans les pages de résultats des moteurs de recherche (SERP). Il est primordial de vérifier régulièrement le contenu du fichier robots.txt à l'aide d'outils de validation SEO pour assurer que sa configuration favorise efficacement la stratégie de référencement en place, en évitant toute exclusion indésirable des contenus stratégiques.

- Directives mal appliquées : Veiller à ce que les pages clés ne soient pas exclues par inadvertance.

- Erreurs de syntaxe : Corriger les fautes dans la configuration qui peuvent perturber l'accès des crawlers.

- Surveillance continue : Utiliser des outils SEO pour garantir une indexation appropriée.

Conflits entre robots.txt et meta robots

Dans le domaine du référencement naturel, des conflits peuvent survenir entre le fichier robots.txt et les balises meta robots, posant des défis aux webmasters qui cherchent à optimiser l'indexation de leurs sites. Le fichier robots.txt sert principalement à indiquer aux moteurs de recherche quelles parties du site doivent être explorées ou ignorées, tandis que les balises meta robots contrôlent l'indexation et le suivi des liens à un niveau plus granulaire et spécifique. Un conflit typique se produit lorsque le fichier robots.txt bloque l'accès à une page, mais que cette page contient une balise meta robots avec l'instruction "noindex", rendant cette directive inefficace puisque les crawlers n'atteignent jamais la page pour lire la balise. Ce désalignement peut nuire à la visibilité et aux performances du site dans les résultats de recherche. Il est donc indispensable de coordonner ces deux mécanismes en s'assurant que les directives sont cohérentes et étroitement alignées, permettant ainsi une gestion optimisée du crawl budget et une indexation précise des contenus stratégiques.

- Gestion des accès et indexation : S’assurer d’une harmonisation entre robots.txt et meta robots.

- Conflit typique : Blocage des crawlers par robots.txt empêchant l'accès aux balises meta.

- Synchronisation des directives : Éviter les conflits en vérifiant la cohérence dans le contrôle d'accès.

Quelles sont les meilleures pratiques pour le SEO avec robots.txt ?

Limiter l’accès aux pages inutiles pour le référencement

Limiter l'accès aux pages dites inutiles pour le référencement est une approche stratégique essentielle pour optimiser les ressources d'exploration des moteurs de recherche. Dans le contexte de la gestion SEO, cela implique l'utilisation judicieuse du fichier robots.txt pour bloquer les crawlers sur les pages qui n'apportent pas de valeur ajoutée significative, comme les pages de remerciement après soumission de formulaire, les doublons de contenu, ou certains archives de blog. En identifiant et en excluant ces sections, un site peut maximiser son crawl budget en orientant les efforts d'exploration vers des contenus véritablement stratégiques. Cette pratique aide non seulement à améliorer l'efficacité du crawl, mais renforce également la capacité du site à indexer plus efficacement les pages pertinentes, assurant une meilleure visibilité dans les résultats de recherche. L'implémentation correcte de ces stratégies simplifiées par des outils comme HyperOptimizer offre aux gestionnaires de sites une flexibilité et une précision accrues en matière de visibilité en ligne.

- Gestion stratégique : Focaliser l'indexation sur les contenus à haute valeur ajoutée.

- Exclusion des pages non stratégiques : Eviter le gaspillage de ressources d'exploration.

- Optimisation du crawl budget : S'assurer que le crawl couvre efficacement les pages prioritaires.

Optimiser le crawl sans impacter l’indexation

Optimiser le crawl sans impacter l’indexation est une tâche délicate qui nécessite une orchestration précise des directives du fichier robots.txt et des balises meta robots. Le but est de prioriser l'accès des crawlers aux pages à haute valeur ajoutée tout en assurant une couverture complète de l'indexation souhaitée. Pour ce faire, il est crucial d'implémenter des directives Disallow de manière stratégique pour éviter que le crawl ne gaspille des ressources sur des contenus non essentiels. Parallèlement, l'utilisation de balises noindex sur des pages peu pertinentes doit être ajustée de sorte qu'elles ne privent pas involontairement les pages cruciales d'une bonne visibilité. L'analyse régulière des données du serveur et l'exploitation des outils d'analyse avancée, notamment ceux intégrés dans HyperOptimizer, permettent d'affiner ces configurations et de vérifier qu'aucune page d'importance critique ne soit laissée hors de l'indexation. Cette approche garantit un crawl optimisé, améliorant ainsi la performance SEO globale sans réduire l'indexation des ressources essentielles.

- Directives stratégiques : Ajustement des accès pour maximiser l'efficience des crawlers.

- Équilibrage des balises : Assurer une couverture complète tout en optimisant le référencement.

- Surveillance et ajustement : Vérifier l'indexation correcte des pages de valeur.

S’assurer d’une mise à jour régulière en fonction des besoins

S’assurer d’une mise à jour régulière du fichier robots.txt est essentiel pour adapter sa stratégie SEO aux changements et évolutions d'un site web. Une telle attention permet de garantir que les directives restent pertinentes face aux nouvelles configurations de pages, aux changements structurels, ou aux mises à jour de contenu. En adoptant une approche proactive, les gestionnaires de sites peuvent ajuster les règles d'exclusion ou d'autorisation en fonction des nouvelles stratégies de référencement ou des modifications de l'architecture du site. Un audit régulier à l'aide d'outils d'analyse avancés, tels que ceux offerts par HyperOptimizer, permet de détecter les anomalies potentielles et d'assurer que toutes les sections importantes du site sont correctement comptabilisées pour l'indexation. Cette approche vigilante aide à maintenir un équilibre optimal entre l'exploration de pages vitales pour le SEO et la sécurisation des informations sensibles, contribuant ainsi à une performance maximale et à une meilleure gestion du crawl budget.

- Updates fréquents : Maintenir la pertinence des directives avec l'évolution du site.

- Audits réguliers : Identification proactive des zones de risque SEO.

- Sécurisation stratégique : Protection des données sensibles tout en maximisant le référencement.

Le fichier robots.txt a-t-il un impact direct sur le référencement ?

Effets sur l’exploration mais pas sur le classement

Bien que le fichier robots.txt joue un rôle crucial dans la gestion de l'exploration des sites par les moteurs de recherche, il n'a pas d'impact direct sur le classement des pages dans les résultats des moteurs de recherche. Le fichier influence la manière dont les robots accèdent aux différentes sections d'un site, en permettant d’économiser le crawl budget et de concentrer les efforts d'exploration sur les pages jugées stratégiques. Toutefois, la priorité des pages dans les SERP (Search Engine Results Pages) est déterminée par des facteurs plus complexes, tels que la qualité du contenu, les liens entrants, et d'autres éléments SEO hors page. En d'autres termes, bien que le robots.txt puisse limiter ou encourager l'exploration de certaines pages, il ne détermine pas comment le contenu est évalué ou classé une fois qu'il est indexé. Il est donc essentiel d'utiliser le fichier à bon escient pour optimiser l'exploration efficace sans craindre qu'il n'affecte directement le positionnement des pages dans les résultats de recherche.

- Gestion de l'exploration : Orientation des bots sans influencer le rang.

- Focus sur l'indexation : Maximiser la visibilité des contenus stratégiques.

- Facteurs de classement : Dépendants de la qualité et des signaux externes, pas du robots.txt.

Cas où robots.txt peut nuire au SEO

Mal configuré, le fichier robots.txt peut, dans certains cas, avoir des effets néfastes sur le SEO d'un site. L'un des problèmes les plus fréquents survient lorsque des directives Disallow inadéquatement appliquées restreignent l'accès des bots à des pages qui devraient, en fait, être indexées pour améliorer la visibilité du site. Si des sections clés telles que les pages de produits ou les articles de blog se retrouvent bloquées, cela peut réduire considérablement le trafic organique et nuire au taux de conversion. De plus, une approche trop agressive de blocage peut empêcher les moteurs de recherche de voir des fichiers CSS ou JavaScript essentiels qui influencent l'apparence et les performances du site web, donnant une image déformée du contenu. Il est donc crucial de tester régulièrement le fichier robots.txt avec des outils SEO afin d'éviter les erreurs de configuration et d'assurer son alignement avec les objectifs de référencement, en minimisant les risques qui pourraient résulter de blocages intempestifs ou non réfléchis.

- Blocages incorrects : Blocage involontaire de pages cruciales pour le SEO.

- Répercussions sur le trafic : Diminution potentielle du trafic et des conversions.

- Visibilité des ressources : Assurer que tous les éléments nécessaires au rendu du site sont accessibles.

Stratégie SEO intégrant correctement le fichier robots.txt

Une stratégie SEO efficace doit intégrer de manière judicieuse le fichier robots.txt pour gérer l'accès des moteurs de recherche de façon stratégique. Ce fichier, lorsqu'il est utilisé méticuleusement, devient un outil puissant pour guider les robots vers les ressources qui offrent le plus de valeur ajouter au référencement, tout en protégeant les sections sensibles du site. L'intégration réussie du robots.txt commence par une identification claire des pages vitales à indexer et celles à exclure du crawl, se basant sur une analyse des besoins en SEO du site. En conjonction avec un plan de référencement global, ce fichier peut être optimisé grâce à des directives spécifiques User-agent et Disallow, permettant de prioriser les contenus selon leur importance stratégique. HyperLinker.ai, à travers ses outils avancés comme HyperOptimizer, facilite ce processus en offrant des insights dynamiques pour ajuster et affiner continuellement la configuration du fichier, assurant un alignement précis avec les objectifs SEO. Cela permet non seulement d'améliorer l'efficacité de l'exploration, mais également d'optimiser le retour sur investissement en maximisant la visibilité en ligne.

- Optimisation stratégique : Planification précise des accès robots selon la valeur SEO.

- Directive ciblée : Utilisation de User-agent et Disallow pour guider les explorations.

- Analyses dynamiques : Ajustements continus basés sur les insights d'HyperOptimizer.

Quand et comment mettre à jour un fichier robots.txt ?

Identifier les besoins en modification

Pour identifier les besoins en modification d'un fichier robots.txt, il est fondamental de procéder à une analyse approfondie des performances actuelles du site et de son environnement concurrentiel. Une telle démarche commence par une évaluation des résultats d'indexation et d'exploration du site à l'aide d'outils SEO avancés. Ces outils permettent de détecter les segments du site qui ne bénéficieraient pas d'une couverture optimale en termes de crawl budget ou d'indexation. HyperLinker.ai facilite ce processus en fournissant des indicateurs pertinents sur la visibilité actuelle des pages et en proposant des recommandations pour ajuster les règles d'accès selon les priorités stratégiques. En outre, il est crucial d'identifier les pages de faible valeur ajoutée, qui pourraient être exclues du crawl pour allouer plus efficacement les ressources d'exploration aux sections stratégiques. Ce diagnostic doit être périodiquement révisé pour garantir que les directives du fichier robots.txt restent en accord avec l'évolution du site et ses objectifs SEO.

- Analyse des performances : Détection des sections nécessitant des modifications.

- Révision des directives : Ajuster les accès en fonction des priorités SEO.

- Surveillance continue : Mise à jour régulière pour alignement des objectifs SEO.

Planification des mises à jour pour éviter les erreurs

La planification des mises à jour du fichier robots.txt est une démarche indispensable pour éviter les erreurs pouvant impacter négativement le SEO d'un site. Une approche stratégique consiste à établir un calendrier régulier de révision du fichier, s'alignant sur les périodes clés de refonte du site ou de lancement de nouvelles campagnes marketing, afin de s'assurer que les directives restent pertinentes et efficaces. L'utilisation d'outils tels qu'HyperOptimizer de HyperLinker.ai permet de surveiller en continu les performances du robots.txt et de détecter automatiquement les anomalies ou les opportunités d'amélioration. En planifiant des audits réguliers, les gestionnaires de sites peuvent identifier les sections nécessitant des ajustements, prévenir les erreurs de configuration pouvant nuire à l'indexation et optimiser l'utilisation des ressources du crawl budget. Cela garantit que les moteurs de recherche accèdent de manière optimale aux contenus de haute valeur ajoutée, tout en sécurisant les données sensibles, contribuant ainsi à un SEO robuste et durable.

- Calendrier de révision : Planification des mises à jour selon l’évolution du site.

- Surveillance continue : Utilisation d'outils pour détecter les anomalies.

- Audits réguliers : Assurer l'alignement des directives avec les objectifs SEO.

Vérification après modification pour s’assurer du bon fonctionnement

Après avoir modifié le fichier robots.txt, il est crucial de procéder à une vérification exhaustive pour s’assurer de son bon fonctionnement. Cette étape comprend l'utilisation d'outils tels que Google Search Console pour tester et valider que les directives du fichier sont implémentées correctement et respectent les intentions SEO du site. Il est impératif de contrôler que toutes les sections stratégiques destinées à être explorées sont effectivement accessibles par les crawlers, et inversement, que les pages devant rester confidentielles sont bien exclues. En outre, une revue des journaux de serveur peut s'avérer utile pour confirmer que les modifications n'ont pas introduit de blocages involontaires pour les robots d'exploration. HyperOptimizer, outil intégré à HyperLinker.ai, offre également des capacités d'analyse continue pour identifier rapidement toute anomalie post-modification. Cet examen attentif garantit le maintien d'un SEO efficace et la protection des données sensibles, évitant ainsi des impacts négatifs sur la visibilité et le classement du site dans les résultats de recherche.

- Validation complète : Utiliser des outils pour tester les directives modifiées.

- Contrôle des accès : Vérification des sections accessibles et protégées.

- Analyse de logs : Assurance contre les blocages involontaires via les journaux de serveur.